Искусственный интеллект (ИИ) является основой современной робототехники и виртуальных помощников. Его навыки обработки данных и анализа намного превосходят индивидуальные человеческие возможности. Однако преимущества использования ИИ несколько сглаживаются сомнительной этикой, стоящей за гуманизацией этой «умной» технологии, сообщает payspacemagazine.com.

Фото: depositphotos.com

Искусственный интеллект в двух словах

Искусственный интеллект — не сложное понятие. По сути, это технология, способная выполнять сложные задачи, аналогичные некоторым ментальным процессам человека. В частности, ИИ может классифицировать и анализировать данные, выявлять закономерности, выводить причины и последствия событий, принимать решения и суждения, распознавать естественную речь и даже генерировать креативный контент.

Мы не будем углубляться в технические детали того, как все это работает. Проще говоря, алгоритмы искусственного интеллекта представляют собой ряд инструкций, которые позволяют программному обеспечению распознавать и анализировать закономерности и особенности данных. С помощью машинного обучения ИИ может учиться на заданных наборах данных и принимать решения или делать прогнозы без явного программирования.

Новейшее подмножество искусственного интеллекта — генеративный ИИ или сокращенно GenAI — представляет собой тип технологии, которая может создавать различные типы оригинального контента, включая текст, изображения, программный код, аудио и синтетические данные.

Почему люди очеловечивают ИИ

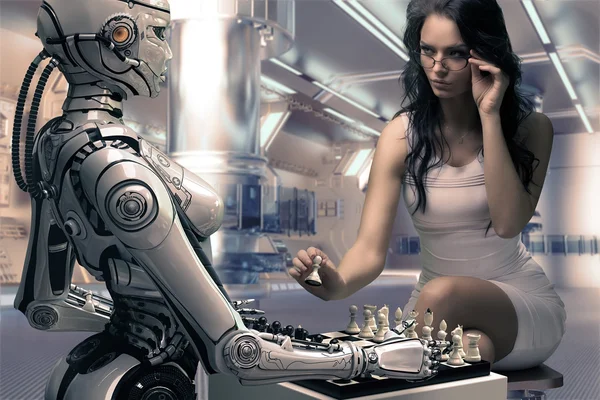

Хотя мы неоднократно заявляем, что ИИ — это технология, она становится все более и более человекоподобной. Более того, это происходит намеренно. Разработчики и создатели инструментов ИИ явно имитируют стили человеческого общения и создают человекоподобные аватары для своих помощников ИИ. Почему мы пытаемся сделать разумные человеческие копии из набора алгоритмов?

Для начала, люди любят себя. Они достаточно эгоцентричны, чтобы создать теорию антропоцентризма — этического убеждения, что только люди обладают внутренней ценностью, в то время как все остальные существа имеют лишь инструментальную ценность в своей способности служить людям. Неудивительно, что мы видим так много человекоподобных роботов и очеловеченных чатботов.

Другая причина в том, что ИИ часто используется для замены функции гипотетического сотрудника или профессионала. Возьмем, к примеру, консультанта по моде. ИИ может анализировать тип телосложения человека и другие особенности внешности, чтобы давать рекомендации по различным персонализированным стилям. Однако клиент может предпочесть услышать это от стильного, приятного на вид человека (пусть даже виртуального), а не от безличного чат-бота.

Кроме того, существуют области, в которых люди используют ИИ для выполнения своей работы, не давая другим знать, что они использовали помощь технологий. Это типично для написания текстов или кодов, создания резюме, брифингов или даже маркетингового контента. В этом случае люди склонны представлять созданный ИИ материал как свой собственный. Поэтому они пытаются сделать его искусственную природу труднообнаружимой с помощью методов «очеловечивания», например, добавляя личную историю, примеры из реального мира и другие виды эмоциональной привлекательности.

Этические последствия очеловечивания ИИ

Очеловечивание ИИ влечет за собой целый ряд рисков, которые необходимо тщательно продумать.

Возможный обман

Начнем с того, что очеловечивание ИИ иногда может стирать границы между человеком и машиной. Это приводит к двусмысленности, когда пользователи не всегда точно понимают, с кем они общаются. В лучшем случае они будут следовать советам по покупкам или образу жизни от инфлюенсера-робота, который может продвигать еще более нереалистичные стандарты красоты, чем реальные создатели Instagram. Однако все может стать еще серьезнее, если технология будет использоваться преступниками.

Высокогуманизированный ИИ может эксплуатироваться в таких областях, как маркетинг, политические кампании или социальная инженерия. В этом случае вы можете легко перевести корпоративные деньги на счет злоумышленника, обманутого дипфейковым сообщением руководителя, или очернить имя вашего бренда в дипфейковой вредоносной кампании. Кроме того, если создатели совершенно легальных человекоподобных инструментов ИИ или виртуальных личностей не заявляют четко и недвусмысленно, что это машина, это может привести к потере доверия не только к этому конкретному продукту ИИ, но и к более широкой технологии.

Увековечивание предубеждений

Другая этическая проблема заключается в том, что человекоподобные ИИ-боты могут увековечивать предубеждения или вести себя несправедливо или дискриминационно. Благодаря своему человеческому подобию такие опасные идеи могут звучать более убедительно и привлекательно. Если это произойдет, кто будет нести ответственность? В какой степени реакции очеловеченной технологии зависят от ее создателей и каковы правовые последствия таких случаев?

До сих пор один из подходов к регулированию ИИ в основном фокусировался на саморегулировании и самооценке разработчиков ИИ. Однако это оказывает слишком большое давление на частный сектор. Между тем, системы ИИ, которые используются в системе уголовного правосудия для прогнозирования будущего преступного поведения, уже были замечены в усилении дискриминации и подрыве прав, включая презумпцию невиновности, по словам Комиссара ООН по правам человека. Была ли это вина разработчика, самой технологии или наборов предвзятых данных, на которых она обучалась? Самое главное — как предотвратить распространение таких предвзятых приложений ИИ, особенно в высокогуманизированной форме?

Чрезмерная зависимость от ИИ

Когда технология выглядит как человек, говорит как человек и ведет себя как человек, гораздо проще приписать ей человеческие качества, включая надежность, достоверность и лояльность. Несколько исследований показывают, что ИИ, наделенный человеческими качествами, как правило, пользуется большим доверием в потребительских условиях, банковском секторе, сфере услуг, туристической индустрии и личном использовании. Многие люди склонны верить информации, которую они получают от ИИ, не проверяя ее. Она может быть невинной, если это хакерская атака, но подумайте о возможности появления похожего на человека помощника врача ИИ, который дает вам неправильные советы по жизненно важным вопросам. Это может иметь решающее значение.

ИИ также часто используется как тип личного компаньона для одиноких людей или даже аналог терапевта. Одним из примеров является новое ожерелье Друг на базе ИИ , которое составляет людям компанию в повседневных разговорах. Наверняка есть похожие проекты с участием очеловеченной личности ИИ или робота. Эти инструменты, безусловно, могут иметь некоторое положительное влияние. Однако чрезмерная зависимость от ИИ для общения или эмоциональной поддержки может усугубить проблемы с психическим здоровьем. У компаньонов ИИ нет настоящего эмоционального интеллекта, который помог бы реальным людям заметить некоторые красные флажки в человеке. Кроме того, они могут не полностью удовлетворять эмоциональные потребности человека. Тем не менее, из-за их человеческого сходства пользователи могут ожидать этого от систем ИИ и разочаровываться или даже впадать в депрессию, когда они не выполняют функцию настоящего друга-человека или терапевта.

Должен ли гуманизированный ИИ получить некоторые права?

Слишком сильная гуманизация ИИ может в конечном итоге создать этические дилеммы о правах и обращении с системами ИИ. Если мы научим искусственный интеллект думать и принимать решения как люди, следует ли относиться к нему также как к людям? В конце концов, мы несем ответственность за тех, кого приручили. Чем более гуманизирована технология, тем сложнее становятся моральные соображения об ответственности человека по отношению к этим системам.

Некоторые дискуссии уже возникают на индивидуальном уровне. Например, следует ли нам обращаться к чат-ботам вежливо, используя «пожалуйста» и «спасибо», как в межличностном общении, или просто относиться к ним как к поисковой строке Google? Если вы получите два противоположных совета от эксперта-человека и хорошо обученного чат-бота ИИ, кому вы скорее поверите?

В какой степени мы должны доверять цифровым агентам ИИ? Некоторые компании уже изучают возможность назначения виртуальных помощников на базе ИИ с цифровыми кошельками для совершения автономных платежей по запросам от нашего имени. Итак, как далеко мы зайдем? Используем ли мы помощников ИИ в качестве компаньонов, преподавателей, партнеров по исследованиям, HR, фитнес-инструкторов ? Если да, то какую автономию мы должны им предоставить? И как с ними обращаться? Если мы не разговариваем с ботами ИИ уважительным образом, нормализуем ли мы грубое общение в ответ? Эти риторические вопросы — лишь вершина айсберга, когда речь заходит об этих сложных этических дилеммах.

Что можно со всем этим сделать?

ИИ — это новая технология, которая существует всего несколько десятилетий и только несколько лет по-настоящему массово используется. Она быстро развивается, и ни регуляторы, ни представители частного сектора пока не придумали, как с ней правильно обращаться, не говоря уже о потребителях. Хотя нам следует развеять мифы об ИИ и начать масштабировать огромный потенциал этой технологии, нет смысла игнорировать определенные репутационные и этические риски, которые она несет.

Как мы видим, очеловечивание ИИ только усугубляет проблему чрезмерной зависимости и слепого доверия к «умным» чат-ботам. В то же время он может быть почти таким же предвзятым и неправым, как и человек. Не забывайте, что он обучается на данных, созданных людьми, в конце концов. Кроме того, есть так много преступников и недобросовестных людей, которые хотели бы манипулировать технологией, чтобы получить больше денег или власти.

Этические и правовые рамки устанавливают необходимые границы

Поэтому нам необходимо разработать определенный кодекс этики, а также основные правила безопасности для работы с человекоподобным ИИ и всеми другими типами этой технологии. Четкая этическая структура может помочь предприятиям и регулирующим органам принимать ответственные решения относительно инструментов ИИ. Например, должны быть четкие правила, которые не позволяют маскировать сгенерированную ИИ личность под настоящего человека на онлайн-ресурсах и в социальных сетях. Разработчики компаньонов и помощников ИИ не должны переходить тонкую грань между добавлением эмоциональной риторики для обеспечения более увлекательной и эффективной поддержки и попыткой заменить настоящее человеческое общение, эмпатию или квалифицированную помощь специалиста по терапии.

Цифровые предложения ИИ должны разрабатываться с учетом потребностей и благополучия отдельных лиц и общества, а не с манипулятивными целями. Каждый потребитель, который имеет дело с очеловеченным ИИ-ботом, должен получить подробную информацию о том, как на него могут прямо или косвенно повлиять его автоматизированные решения. Не только персоны ИИ требуют явной маркировки, но и все другие ограничения ИИ должны быть очевидны. Информированные пользователи с меньшей вероятностью будут формировать нереалистичные ожидания или станут чрезмерно полагаться на инструменты ИИ, особенно в критических секторах.

Такие раскрытия должны быть стандартизированы, а права потребителей должны быть защищены законом так же, как и в других рискованных секторах, особенно учитывая, что агенты ИИ все чаще несут ответственность за финансовые решения. Также должен быть контрольный механизм для проверки того, реализуют ли разработчики ИИ надежные меры для обнаружения, уменьшения и устранения предвзятости в моделях ИИ. Разнообразные наборы данных, тестирование на справедливость и постоянные аудиты могут помочь гарантировать, что ИИ не увековечит и не усилит социальные предвзятости. Кроме того, поставщики услуг ИИ и регуляторы должны гарантировать, что пользователи информированы и согласны с тем, как их данные собираются, используются и хранятся системами ИИ. Надежные меры защиты данных помогут защитить конфиденциальность пользователей.

Учитывайте отзывы пользователей при проектировании гуманизированного ИИ

Подумайте о возможности того, что чрезмерно очеловеченные модели ИИ могут вызывать у некоторых клиентов чувство дискомфорта и беспокойства. Таким образом, было бы неплохо, если бы пользователи имели возможность настраивать свое взаимодействие с ИИ, регулируя уровень человекоподобного поведения или эмоциональной вовлеченности в соответствии со своими предпочтениями и уровнями комфорта.

Разработчики также могут поощрять обратную связь от пользователей для улучшения систем ИИ и решения проблем с гуманизацией. Прислушиваясь к пользователям, разработчики могут вносить необходимые коррективы и улучшения, отслеживать, как используется ИИ, подвергается ли он манипуляциям, оценивать его влияние на пользователей и любые непреднамеренные последствия. Если вам нужно внедрять человекоподобные функции ИИ, делайте это постепенно, давая время изучить их влияние на пользователей и вносить коррективы по мере необходимости.

Совместные усилия наиболее эффективны

Этические последствия гуманизации ИИ сложны. Поэтому они требуют комплексных мер, которые не зависят от одного законодательного или творческого субъекта. Сообщества должны поощрять постоянные исследования социальных, психологических и этических последствий гуманизации ИИ. Сотрудничество между разработчиками ИИ, этиками, психологами, социологами и другими экспертами может дать информацию о лучших практиках и политиках и улучшить общественное понимание последствий и воздействия таких систем.

Автор Нина Бобро

Источник payspacemagazine.com