FrontierMath стал самым настоящим вызовом для ChatGPT и Gemini, сообщает unian.net.

Фото : DALL-E

Похоже, что до технологической сингулярности нам ещё далеко. Исследователи из организации Epoch AI представили новый математический бенчмарк FrontierMath, с которым пока не справляются даже самые продвинутые модели искусственного интеллекта.

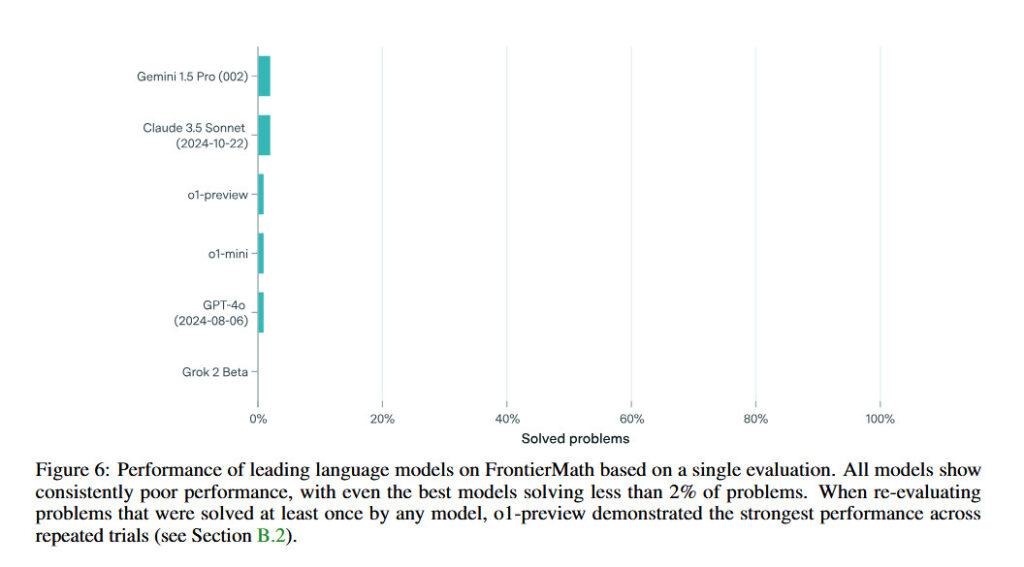

FrontierMath содержит в себе множество сложнейших математических выражений. Модели Claude 3.5 Sonnet, GPT-4o, o1-preview и Gemini 1.5 Pro решают меньше двух процентов задач. При этом во время тестированя у ИИ есть полный доступ к среде Python для обчислений и дебагинга. Для сравнения, в более старых бенчмарках, вроде GSM8K или MATH, модели правильно решают более 90% уравнений.

Главной особенностью FrontierMath является то, что задачи оттуда ранее нигде не публиковались, то есть нейросети не могли заранее обучиться решать такие выражения.

Рейтинг нейросетей по прохождению FrontierMath

Как видно на графике, самой продуктивной моделью оказалась Gemini 1.5 Pro, но даже она смогла решить менее 2% задач. Главным аутсайдером стала LLM от Илона Маска Grok 2 Beta, которая сейчас тестируется в Twitter, она не смогла решить ни одного уравнения.

Для создания теста FrontierMath было задействовано 60 математиков из университетов по всему миру. Задачи в бенчмарке охватывают множество областей, включая теорию чисел и алгеабраическую геометрию. У специалистов может уйти несколько дней, чтобы решить одну задачу из теста.

Автор Иван Назаренко

Источник unian.net